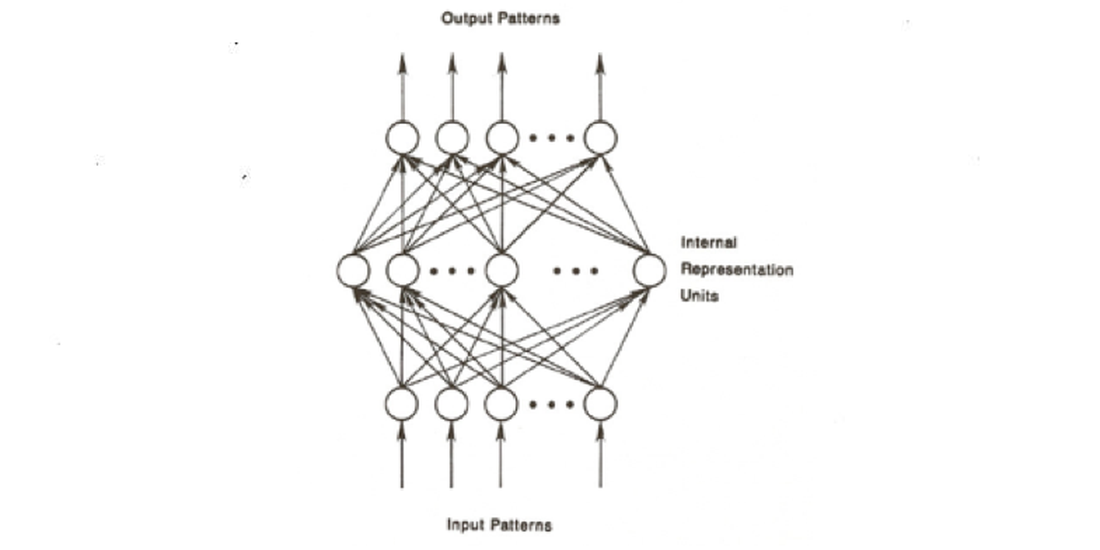

El artista Max de Esteban le “pide” a una máquina que haga un autorretrato. No a cualquier máquina, sino a un computador. Y no a cualquier computador, sino a un computador capaz de procesar en paralelo con otros computadores, guiado por un algoritmo que utiliza “retropropagación de errores” para producir “Redes Neuronales Profundas” (RNP). 1Este algoritmo es descrito por mi colega, el artista digital Jason Salavon, como “la salsa secreta” en muchas formas de procesamiento de alta complejidad. Fue presentada por primera vez en un artículo clásico, “Learning Representations by Back-Propagating Errors”, Nature (October, 1986) Vol. 323:9, 533-36Estas redes insertan capas intermedias de conexiones entre las entradas y salidas. Entonces el algoritmo compara la entrada con la salida, para así detectar cualquier discrepancia o error, y luego “pesa” las capas intermedias para corregir esos errores y hacer que la salida coincida mejor con la entrada. Este proceso es especialmente importante en la visión por computadora, donde, por ejemplo, la cámara del computador podría tomarme una foto y luego enviar una señal para imprimirla con mi nombre adjuntado. Pero supongamos que la luz ha cambiado desde que se tomó la foto inicial, y cuando el algoritmo compara la entrada con la salida, estas ya no coinciden. Un proceso de aprendizaje supervisado ejecuta la nueva entrada para corregir los errores y, pronto, el computador puede reconocer mi rostro más rápido que cualquier humano.

El problema de que la Red Neuronal Profunda tome su autorretrato, afirma De Esteban, es “que no teníamos uno real como referencia”. La RNP, como el computador, no tiene rostro, es una caja negra.2Esto puede ser el motivo por el cual tan a menudo las películas de ciencia ficción presentan a los computadores con rostros, nombres propios e incluso cuerpos. Parece haber un profundo deseo de que la computadora “muestre su cara” y proporcione un avatar que pueda entrar en un diálogo con el usuario. El mejor ejemplo reciente de esto es Her (Spike Jonze, 2013) en la que una “asistente personal” digital entra en una relación amorosa con su “usuario” humano. La inteligencia invisible representada por la voz de Scarlett Johansen quiere aprender de qué se trata la sexualidad humana, y alquila un avatar femenino humano como consejero sexual para satisfacer su curiosidad. Un avatar biocibernético igualmente poderoso es la heroína de Ex Machina (Alex Garland, 2014) una película sobre un robot de alto rendimiento que ha dominado el arte de la seducción, traición y abandono. Hay alguien que recuerde que la palabra “robot”, y el primer ejemplo del concepto, fue un personaje femenino en la obra de Karel Capek de 1920, R.U.R.(Robots Universales Rossum) Es como el viejo dilema baudrillardiano. No hay un “yo” original para comparar con la “selfie” (Juego de palabras intraducible: No original “self” to check against the “selfie”). No hay algo que proporcione la entrada para ser cotejada con la salida, y por lo tanto no hay manera de participar en el aprendizaje supervisado o la retropropagación de errores. No hay un “original” que proporcione un estándar para detectar errores en la copia resultante.

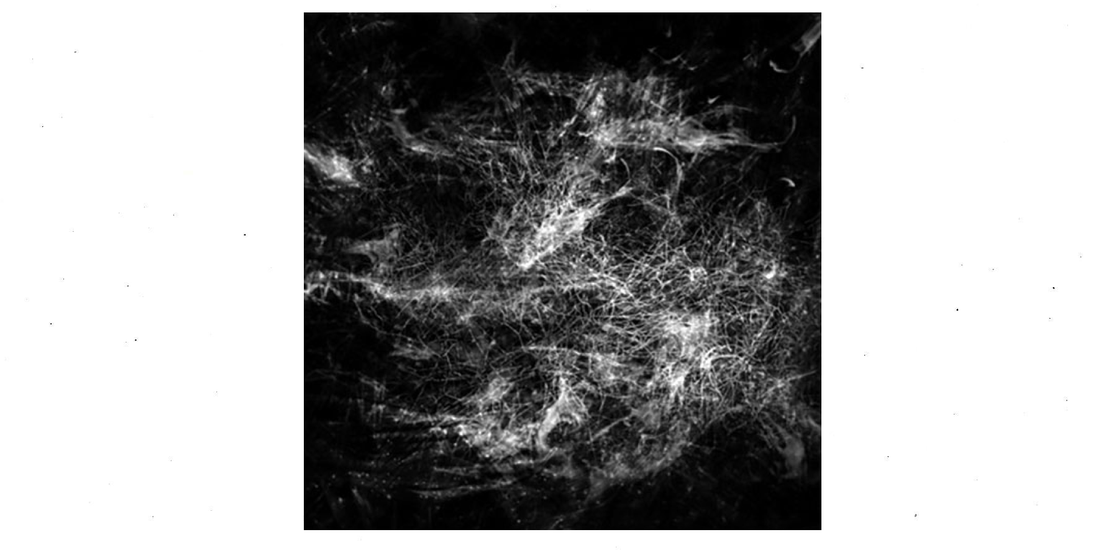

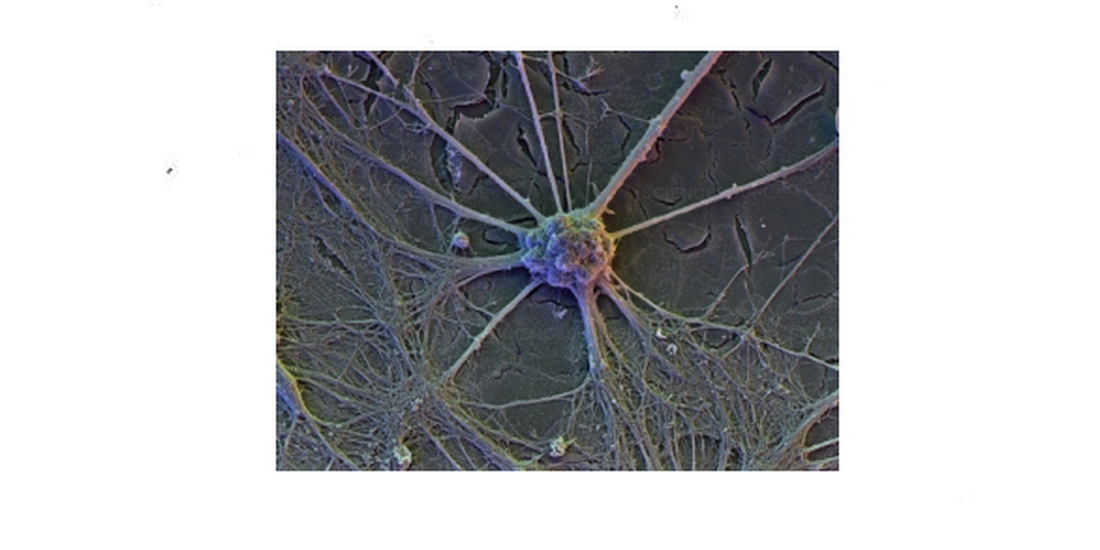

Sin embargo, la Red Neuronal Profunda produce imágenes en respuesta a la orden de mostrarse. Sabe lo suficiente como para hacerlo. Y las imágenes resultan tener un asombroso parecido a imágenes de un tipo radicalmente diferente. Envié copias de los selfies de la RNP de De Esteban a mi joven y brillante sobrina, Christine Ryan, quien se describe a sí misma como una “humilde neurocientífica celular”. Ella informa que “la parte más interesante de todo esto es cómo se relaciona/emparenta con el cerebro real”, es decir, el cerebro humano. “Las llamadas ‘unidades’ en estas redes neuronales se supone que modelan las neuronas biológicas reales, que son mucho más complejas que las máquinas de entrada y salida descritas por este tipo de modelos computacionales.” 3Correspondencia por mail con el autor, 31 de julio de 2019

Pero “mucho más complejas” es una cuestión de grado, no de tipo. Y así llega el extraño momento cuando uno compara una imagen de tejido cerebral (el que sin duda tiene un original físico real en el mundo) con la selfie producida por la Red Neuronal Profunda de Esteban. Son similares, o tal vez “no disímiles”. Se parecen entre sí, son “icónicas” como diría el filósofo Charles Sanders Peirce, compartiendo una primeridad o cualidad de similitud. ¿Cuál es esa cualidad? No son los diagramas de árbol o las redes de diagramas esquemáticos de entrada y salida que los ingenieros proporcionan para ilustrar las redes de retro-propagación de error de las Redes Neuronales Profundas. A lo que se parecen resulta ser una tercera cosa, un fenómeno totalmente familiar del mundo natural, a saber, un bosque.

Así que ahora tenemos tres cosas delante de nosotros: una sección del cerebro humano con sus neuronas y dendritas; una selfie de un computador inteligente que puede aprender; y un denso ecosistema lleno de diversas plantas, parásitos, insectos, aves, reptiles y mamíferos. Posicionado en la escala de complejidad y diversidad, seguramente el bosque es la entidad más compleja, con el cerebro humano en algún lugar entre él y de la computadora inteligente. El “Aprendizaje Profundo” del que es capaz la neurociencia computacional se parece más al de un insecto que al del cerebro humano.4 Sobre el parecido de una Red de Aprendizaje Profundo con el sistema nervioso de un insecto (link) Pero eso no es un insulto a la IA en un momento en el que los ordenadores pueden simular, no sólo el comportamiento de un solo insecto, sino el de todo un enjambre, con poderosos potenciales para la guerra de drones.5Ver Katherine Hayles para una notable aplicación práctica de esto

Los íconos son lo que Peirce llama “cualisignos”, signos que significan en virtud de su semejanza con lo que representan. Entonces, ¿cuál es la cualidad que vincula al computador inteligente con la célula cerebral del bosque? Hacer la pregunta es inmediatamente vislumbrar la respuesta: es la forma que Gilles Deleuze y Félix Guattari llamaron el rizoma, “una imagen del pensamiento”, un modelo no jerárquico de pensamiento que es contrastada con la forma “arborescente” o jerárquica de árbol que nos es familiar desde la lógica 6Mil mesetas. Véase también Hannah Higgins, acerca del bosque como una forma fractal que proporciona una interfaz viva entre la tierra y el cielo (especialmente la luz del sol). De manera similar, el cerebro es como un planeta en el que todas las funciones de la inteligencia superior están localizadas en la superficie como una especie de “relleno” (ver también Malabou).

El rizoma de Deleuze y Guattari ahora ha sido literalmente actualizado, no a nivel del pensamiento humano, sino en una reflexión antropológica sobre los bosques. Eduardo Kohn, antropólogo, hace la pregunta “¿Pueden pensar los bosques?” y responde enfáticamente de modo afirmativo 7Kohn, How Forests Think (University of California Press, 2013). Kohn afirma que el pensamiento no es exclusivamente humano, extendiéndose a todos los seres vivos. Y toma al ecosistema por sí mismo como una totalidad, un sistema de relaciones que en sí mismo tiene vida. ¿Tienen los bosques, entonces, la durabilidad temporal de una especie orgánica, un género, un “reino” o un “clado” (la unidad evolutiva de la clasificación biológica contemporánea)? ¿Son los bosques una especie u organismo espacial y colectivo, algo así como comunidades o ciudades? ¿Son estas “meras metáforas”, peligrosamente cercanas al tipo de pensamiento que ha fundado las ideas de la conciencia racial? ¿O son “metáforas absolutas” incorregibles, como sugiere Hans Blumenberg, tropos e imágenes de las que no podemos escapar? ¿Hasta dónde podríamos llevar esto? ¿Piensan los planetas? ¿Bruno Latour estaría en lo cierto cuando compara la ecología de la superficie de la tierra con la antigua diosa llamada Gaia, dándole un rostro humano al medio ambiente?

Curiosamente, dada la promiscuidad que hay en su extensión del pensamiento a los no-humanos, Kohn descarta a las máquinas en cuanto cosas pensantes.8 Aún más curioso es su fracaso en citar, y mucho menos discutir, el clásico de la etnografía Colin Turnbull sobre los pigmeos congoleños, The Forest People (NY: Simon & Schuster, 1962)9edición en español: La gente de la selva, Milrazones, 2011, el que documenta su creencia de que el bosque es una deidad y, también, “Madre y Padre, Amante y Amigo”. Quizás este es el porqué Esto parece un error. Las formas “naturales” de inteligencia en plantas y animales suelen describirse en términos de adaptación darwiniana. Los organismos “inteligentes” responden al medio ambiente de manera que aumentan las posibilidades de supervivencia de su descendencia. La inteligencia colectiva, como sostiene Catherine Malabou, “es la sabiduría de la comunidad para adaptarse a cambios de mayor escala”.

En los humanos, la Inteligencia siempre ha sido artificial. ¿Cuándo no fue una cuestión de aguda y cuidadosa observación, escucha y reflexión, seguido por un juicio sobre qué decir o hacer? Kohn argumenta que el bosque está plagado de lo que Peirce llama “inteligencias científicas”, capaces de responder a los estímulos de manera positiva. Como si “supieran qué hacer”. No habitan en un universo simbólico, sino en un mundo de iconos e índices-imágenes e indicadores. Responden a los estímulos y muestran sus respuestas. Las computadoras hacen esto, pero también (junto con los mamíferos superiores) participan en nuestro universo humano y simbólico. Son “extensiones” McLuhanianas de nuestros cerebros, cuerpos y voces. Si los bosques pueden pensar, seguramente las máquinas también pueden. Un bosque no puede jugar al ajedrez, pero sí tiene métodos para repararse a sí mismo después de un incendio.10 Ver Anna Tsing, The Mushroom at the End of the World (Princeton University Press, 2015) sobre el papel de los hongos en la reparación de los bosques después de un incendio o una tala destructiva Las “quemas controladas” son la forma en que los humanos permiten que la inteligencia de un bosque florezca.

Heidegger pensaba que el pensamiento estaba limitado a los seres humanos. Pero también pensó que “todavía no pensamos”. Todavía no hemos aprendido cómo o quizás tampoco sabemos qué es el pensamiento. Filosofar no es pensar. La ciencia no es pensar. El pensamiento más preocupante, para Heidegger, “en nuestro tiempo problemático es el hecho de que no pensamos” 11 NdT: Heidegger, M. ¿Qué significa pensar?, p. 17, Ed. Trotta. Acá Mitchell hace un juego de palabras y rima con la traducción al inglés de Heiddeger (The most thought-provoking thought, for Heidegger, “in our thought-provoking time is that we are still not thinking.”). Lo que en ese pasaje Heidegger entiende por “preocupante” (“thought-provoking”) es lo que da que pensar, lo que debe ser considerado, tomado en cuenta. Por supuesto que uno se pregunta quiénes serían esos “nosotros” y qué evidencia hay de que no estén pensando. Y si “nuestro tiempo” aún no ha alcanzado el verdadero pensamiento, ¿cuándo y cómo empezaremos a pensar?

¿O sería mejor decir que ya hemos empezado a pensar sin darnos cuenta, ni entender cómo lo hacemos, como un niño que aprende a caminar y a hablar sin entender del todo cómo se hace? Heidegger piensa que el pensamiento es principalmente una cuestión de memoria. Pero, como sabemos por la informática, la memoria no lo es todo. También está la cuestión de la velocidad. ¿Cuán rápido es el pensamiento? ¿Qué tan rápidos (y numerosos) son los procesadores? ¿No enseñan los cerebros humanos a las máquinas las artes del procesamiento paralelo y las habilidades de recuperación? Heidegger deja a la imaginación fuera de la ecuación, lo que parece un error. Pensar no es sólo una ocurrencia de último momento o una recuperación más una gran capacidad de memoria. El personaje de Borges con memoria absoluta y total es “Funes el memorioso”, un autista inmovilizado con daño cerebral, que recuerda (es decir, piensa) todo el universo. Pensar es también prever, anticipar y corregir el pasado mediante la “retropropagación de errores”.

Así que tal vez Heidegger estaba doblemente equivocado respecto al pensamiento. El pensamiento no sólo es bastante más que la memoria; no está amenazado por la tecnología y la ciencia, sino que es ayudado por ellas. En lo que sí tenía razón era que “todavía no estamos pensando”(“todavía no pensamos”), en el sentido de que todavía no hemos aprendido lo que el pensamiento puede ser y hacer, y qué efecto está teniendo nuestra falta de pensamiento sobre el pensamiento. El pensamiento es un proyecto incompleto. Ahora tenemos poderosas máquinas para pensar, pero nosotros (y me refiero con esto a nosotros los humanos, nuestra especie en este planeta) aún no hemos aprendido a pensar de una manera que asegure nuestra supervivencia. Aquí es donde la ideología entra en la ecuación, ayudada por la iconología, la ciencia de las imágenes.

Max de Esteban acompaña sus “selfies” rizomáticas de las Redes Neuronales Profundas con un vídeo de 23 minutos que nos lleva a un lento y meditativo paseo por un bosque neblinoso. El paseo se siente incorpóreo, como si el espectador estuviera flotando en el aire, no a pie, quizás un efecto producido por una cámara fija. El paseo parece sin rumbo, ocasionalmente girando hacia lo que parece un sendero, a veces girando a un lado para recorrer la maleza profunda y enredada. Una narración de voz baja masculina medita sobre la aceleración contemporánea de la inteligencia artificial, expresando a veces una leve alarma sobre sus implicaciones para la privacidad y la democracia, mientras nos asegura que los avances tecnológicos son irresistibles e inevitables 12En sus notas sobre A Forest (Un bosque), De Esteban nos dice que esa voz-over es “un monólogo reescrito por el director general de la principal empresa de capital de riesgo que invierte en inteligencia artificial” La voz nos recuerda que la desmotadora de algodón fue inventada en 1793, y como resultado, entre 1800 y 1850 el número de esclavos en América del Sur se multiplicó 600 veces. ¿No se debería haber inventado la desmotadora de algodón? No había elección, nos asegura la voz. La democracia representativa se inventó hace más de 200 años, cuando la mayoría de la gente no sabía leer ni escribir. ¿Está obsoleta hoy en día? ¿Qué la reemplazará en una era de encuestas en tiempo real para averiguar los deseos de una población y de algoritmos que calculan las vulnerabilidades de grandes masas de personas con desinformación, propaganda y mentiras descaradas? ¿Cómo sobreviviremos en una época en que hemos subcontratado nuestro razonamiento a algoritmos que nadie entiende, alojados en cajas negras que escupen unos “resultados” que no son verificables por la inteligencia humana?

La voz-over de De Esteban es tranquila, a veces irónica, a veces ominosa. Su expresión más enfática es un apagado “¡huh!” dirigido a algún dato interesante. No hay rastro de pánico, histeria o tecnofobia exagerada. A medida que la cámara flota en la profundidad del bosque, se acerca a los bordes y precipicios que se perciben débilmente; hacia el final de la película, la niebla se hace más espesa y la luz se desvanece gradualmente a negro. ¿Estamos “perdidos en el pensamiento”, vagando en un bosque? Heidegger, haciéndose eco de la alegoría de Platón de la salida desde una oscura caverna a la luz del día, postula un “claro” o “calvero” (Lichtung) en el bosque 13Heidegger Dictionary, p. 238. . ¿Pero qué pasa si el pensamiento humano es en sí mismo un bosque? ¿Y si todos nuestros esfuerzos por limpiar estos bosques sólo generan nuevos bosques? ¿Podría ser esta la razón por la que nuestras ciudades se comparan tan a menudo con las selvas, y que las redes neuronales profundas de las computadoras producen selfies rizomáticas?

Estas preguntas parecen especialmente pertinentes cuando uno de los mayores peligros para el medio ambiente global es la destrucción de los bosques de todo el planeta. Mientras escribo esto, las antiguas selvas del Amazonas están siendo quemadas y taladas por la agroindustria. Tal vez estos grandes ecosistemas rizomáticos, que funcionan como los pulmones del planeta, son también el mejor modelo del pensar en sí mismo. El modelo adecuado para aprender a pensar, por lo tanto, no sería el desmonte sino la reforestación, una práctica que muestra signos de afianzarse en ciudades postindustriales como Detroit, donde la abundancia de terrenos baldíos ofrece una oportunidad para reimaginar por completo la relación entre la ciudad y el campo.

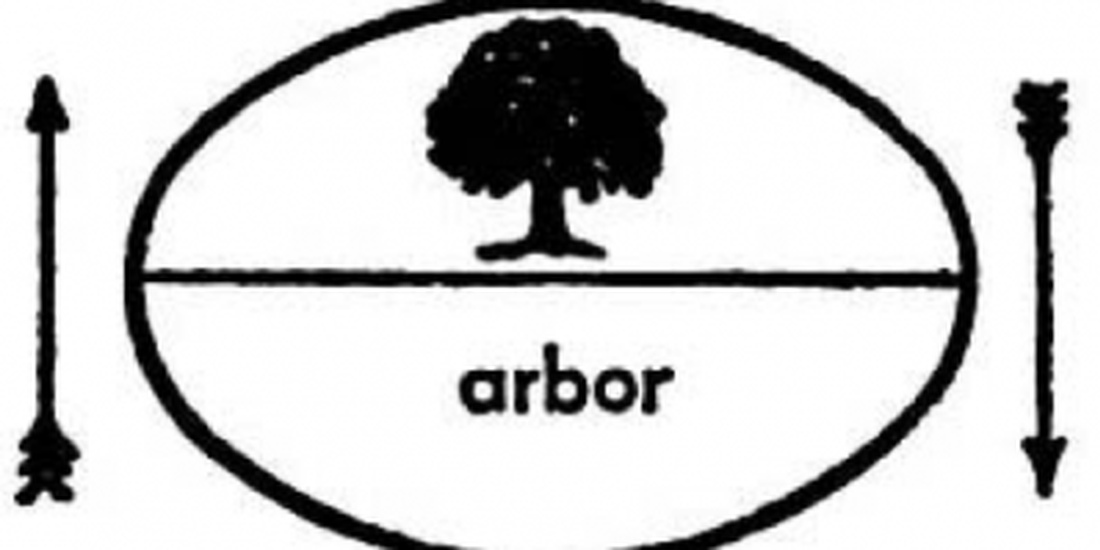

Este tipo de reimaginación del bosque podría ayudarnos a repensar el medio en el que realizamos la mayor parte de nuestro pensamiento, es decir, el lenguaje. Saussure representó notablemente la unidad fundamental del lenguaje en un diagrama que asocia la palabra para árbol (el significante o imagen acústica) con la imagen de un árbol (el significado, imagen mental o concepto) dentro de un óvalo con una barra entre la palabra y la imagen, flanqueada por flechas que indican la transferencia de significado entre la palabra y el pensamiento.

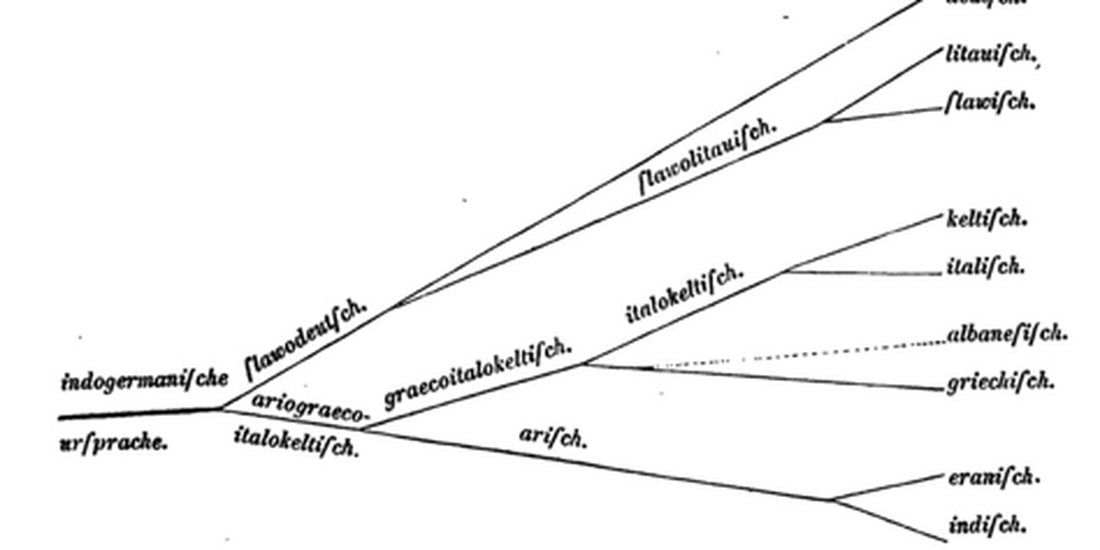

A la luz de esto, ¿qué cosa son el pensamiento y el habla sino un bosque? La pregunta de Kohn, ¿Pueden pensar los bosques? se invierte: ¿puede el pensamiento encontrar un camino hacia la reforestación? El modelo de aligerar de Heidegger retrocede, junto con la reliquia más célebre de la lingüística fundada en la raza, el “árbol genealógico de las lenguas”. Como dice mi colega Haun Saussy:

Esta representación gráfica de las relaciones entre las lenguas fue iniciada por August Schleicher, que resulta ser el teórico que Saussure menos respetaba. Schleicher pensaba que las lenguas eran seres vivos y que nacían, evolucionaban y morían de una forma darwiniana. Los más fuertes (y con eso puedes estar seguro de que se refiere a los dialectos indoeuropeos) sobreviven. Además, una lengua es la expresión de la conciencia de una raza. Saussure odiaba toda esta forma de pensar organicista y recurre una y otra vez a ejemplos que muestran cómo en el curso de su historia la gente puede adoptar una lengua diferente, cómo los significados de los idiomas no derivan del pensamiento sino de infraestructuras materiales como la pronunciación y los sistemas de escritura, y cuán frágil es el concepto de raza14Correspondencia con el autor, 5 de noviembre de 2019.

El árbol es un objeto parcial, una unidad mínima y, absolutamente, el modelo equivocado para la totalidad, que incluye muchas más cosas además de los árboles, así como el lenguaje contiene muchas más cosas además de las palabras, y el pensamiento muchas más cosas además de los pensamientos.

Hoy nos encontramos vagando en un nuevo bosque que hemos plantado y alimentado nosotros mismos, a saber, el mundo de la inteligencia artificial que ahora nos rodea como una segunda naturaleza, basada en nuevas infraestructuras y sistemas de escritura. En tanto nosotros mismos somos descendientes evolutivos de criaturas arborescentes como los primates, de alguna manera parece ser un lugar apropiado donde los humanos lleguen a su fin. Claro que podríamos intentar quemarlo con polémicas tecnofóbicas que niegan la inteligencia de los no humanos, o que lo demonizan como el siniestro enemigo de los valores humanos tradicionales. Esto sería estúpido, y socavaría seriamente la afirmación de que los seres humanos son poseedores de una inteligencia “natural”. De hecho, la inteligencia humana puede, como el “pensamiento” de Heidegger, ser algo que nuestra especie aún no ha logrado. Un punto de partida razonable sería interactuar con nuestras máquinas pensantes como un nuevo entorno, un hábitat que nos desafía a repensar lo que somos o podemos llegar a ser.

El “Bosque” de De Esteban, entonces, es en realidad dos bosques: uno está situado en las infraestructuras de la mente-cerebro humana (memoria, comprensión, voluntad, autoconciencia), re-descrito en el lenguaje e imaginería de la ciencia neurológica (neuronas, etc.) y computacional (entrada/salida). El sujeto humano se explica así como un robot más o menos inteligente, y la máquina es descrita cada vez más como un sujeto -una criatura de hábitos y hábitos rotos, de resolución de problemas y de fracaso estúpido. La otra es la red y los algoritmos de la Inteligencia Artificial, hablando el lenguaje de la neurociencia. Toda inteligencia, al parecer, es “artificial”, un artefacto de interacciones de un sistema con su entorno (para usar los términos de Niklas Luhmann) 15Ver Niklas Luhmann, “Medium and Form”, in Art as a Social System trans Kathleen Cross (Stanford University Press, 2000)16edición en español: “Medio y forma”, en El arte de la sociedad, Herder, 2005) , y mi crítica del sistema/ambiente de Luhmann en “Addressing Media”, What Do Pictures Want? (University of Chicago Press, 2005. Edición en español: “Dirigiéndose a los medios”, ¿Qué quieren las imágenes? Una crítica de la cultura visual, Sans Soleil, 2017) Siempre ha sido así, desde los antiguos sistemas de memoria de la retórica a los inventores de la escritura, los números, el dibujo, el habla. La combinación de lo simbólico con la evolución tecnológica -métodos, herramientas y máquinas- se convierte en la infraestructura del pensamiento -un bosque de chips, enlaces y algoritmos por un lado, y una estructura rizomática de neuronas y conectores por el otro. Por lo tanto, el cerebro orgánico como el de las máquinas no son realmente “yoes” (“selves”) o sujetos. Podrían describirse mejor como “órganos” -partes de organismos- o como “ambientes”, espacios donde viven los organismos. El cerebro no es un “yo” más de lo que lo es un bosque o un árbol.

La fusión de la IA y la neurociencia se enmarca, como señala De Esteban, dentro de la “ideología”, lo que quiere decir, en este contexto, el capitalismo. Aquí pienso en las mordaces reflexiones de Catherine Malabou sobre una cierta “locura” en la arquitectura del cerebro. Resulta que el cerebro no tiene realmente ningún “diseño inteligente”:

De hecho, en su estructura anatómica, el cerebro conserva una organización que atestigua un pasado evolutivo errático en vez de una “concepción óptima” en términos de su funcionamiento… Las circunstancias arbitrarias a las que se enfrentó el organismo durante su evolución se mantienen junto con una especie de “locura” organizativa y funcional en la arquitectura del cerebro. ¡La ‘locura’ está inscrita en nuestras neuronas junto con nuestra capacidad de razonar!”17Malabou, Morphing Intelligence: From IQ Measurement to Artificial Brains (Columbia University Press, 2019), p. 80

¿Y qué pasa con la Inteligencia Artificial? Aquí vuelvo a lo básico: el primer computador autoconsciente de Caja Azul en la historia del cine fue el HAL 9000, quien se vuelve tan paranoico que le da un desenfreno asesino al servicio de un algoritmo que valoraba “la misión” por encima de los humanos que se suponía que la llevaban a cabo. HAL es el personaje más humano en 2001: Odisea del espacio. El protagonista humano, Keir Dullea, es, como su nombre insinúa, muy poco afectivo, mientras que HAL, que vive sólo como una voz, es cálido, preocupado, ligeramente femenino y demasiado emocional. Sus últimas palabras al desconectarse son “Tengo miedo, Dave”. Mientras más complejas y autoconscientes se vuelven nuestras máquinas, más estrechamente simulan la inteligencia humana, más vulnerables se vuelven a la estupidez y la locura. En este momento, sin embargo, los seres humanos están muy por delante de ambos riesgos profesionales de la inteligencia. Como especie, nos hemos convertido en “un peligro para nosotros mismos y los otros”, el criterio legal para el confinamiento involuntario por motivos de locura. Así que tal vez deberíamos considerar a la IA como una entidad coevolutiva, una que debemos poner a trabajar en el mayor y más vital “bosque” que habitamos, el planeta. No podremos salvar nuestro medio ambiente, ecológico o social, sin la ayuda de nuestros compañeros, los computadores. ¿Esto podría ser cierto también para la política, donde el auge de los medios sociales, los trolls, los bots y la desinformación está socavando la democracia representativa? Malabou plantea la pregunta ¿qué tipo de “democracia experimental” podría ayudarnos a diseñar la IA? El experimento estadounidense evolucionó a partir de una democracia fundada en las nociones de razón de la Ilustración y en un equilibrio de poderes diferenciados que reflejan una inteligencia humana constituida por la autorregulación, el juicio y la voluntad (es decir, los poderes del gobierno legislativo, judicial y ejecutivo). ¿Existe un algoritmo que pueda manejar estas formas de procesamiento paralelo? ¿O el pensamiento algorítmico es el más adecuado para poner a circular la desinformación, la paranoia y la histeria colectiva entre poblaciones e individuos especìficos, como pasó con el célebre trabajo de Cambridge Analytica al servicio de las agendas políticas de Brexit y Donald Trump? 18https://en.wikipedia.org/wiki/Cambridge_Analytica

Sería reconfortante culpar a la Inteligencia Artificial de la actual inclinación global hacia las democracias fallidas y dictadores autoritarios. Pero la culpa, querido Bruto, no está en nuestras estrellas ni en nuestro bosque de redes neuronales, sino que en nosotros mismos. Si la locura es una característica estructural de la inteligencia tanto en el cerebro como en la máquina, el otro lado es la estupidez. Como señala Malabou,

La estupidez es el fermento deconstructivo que habita en el corazón de la inteligencia…. Una sola palabra, “inteligencia”, caracteriza tanto al genio -inteligencia natural- como a las máquinas -inteligencia artificial. Un don es como un motor: funciona por sí mismo y no viene de sí mismo. En este sentido, entonces, es estúpido.19Malabou, p. 7

No tenemos otra opción, sino hacer que nuestras máquinas y nosotros mismos seamos más inteligentes. La alternativa es la extinción, que es el tercer componente de la encuesta de Max De Esteban sobre las infraestructuras contemporáneas junto con el capital financiero y la inteligencia artificial. Nuestras máquinas están haciendo un seguimiento cuidadoso de esto. Estamos viviendo el mayor período de extinción masiva desde la desaparición de los dinosaurios, lo que quizás explica por qué se han convertido en el animal tótem de la modernidad.20 Véase mi estudio de este complejo icono cultural, The Last Dinosaur Book (University of Chicago Press, 1998) Aproximadamente 300 especies desaparecen cada día, una cada cinco minutos. Dada su famosa adaptabilidad, la especie humana probablemente pueda sobrevivir a la subida del mar, a la expansión de los desiertos y al aire y agua envenenados dentro de vainas con forma de arca para los muy ricos. Max de Esteban contempla este futuro sin vacilar, desafiándonos a pensar en algo mejor.

Mitchell, W. (2021). El bosque biocibernético, laFuga, 25. [Fecha de consulta: 2025-11-07] Disponible en: http://2016.lafuga.cl/el-bosque-biocibernetico/1047